腾讯交卷了!很争气

撰稿 | 莫言 & 云昭

“国家队”腾讯混元大模型今天终于交卷了!

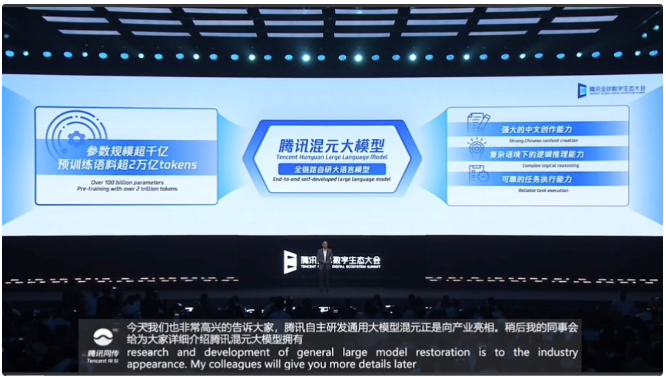

预训练语料超2万亿tokens(GPT3.5只有3000亿tokens),幻觉、超长文本任务处理实测问题超过GPT4,腾讯云、广告、微信搜一搜、小程序等多个生态已经接入测试……的确给出了一张令人耳目一新的答卷。

B端服务同样也给出了不一样的打法:客户可以基于API调用混元,也可以基于混元做专属的行业大模型。此外,腾讯云也全面接入Llama 2、Bloom等20多个主流模型,和混元一样,都支持直接部署调用。

今日举办的腾讯全球数字生态大会上,抖出来的有关混元的“料”实在不少!总结起来,接地气!也很给中国版争气!

1、劲头拉满,赶超GPT4

大模型很“机灵”,但使用场景却非常局限,主要集中在容错率高、任务简单的休闲场景。对此,腾讯在算法层面进行了一系列自研创新,提高了模型可靠性和成熟度。

究其原因,腾讯混元解决了大模型普遍的几个顽疾——

针对大模型容易“胡言乱语”的问题,腾讯优化了预训练算法及策略,让混元大模型的幻觉相比主流开源大模型降低了30%至50%;通过强化学习的方法,让模型学会识别陷阱问题;通过位置编码优化,提高了超长文的处理效果和性能;提出思维链的新策略,让大模型能够像人一样结合实际的应用场景进行推理和决策。

首先,向“幻觉”宣战!一直以来,“幻觉”问题都是大模型的痼疾。在语言模型中,所谓“幻觉”,简单来说就是指一本正经的胡说八道——看似像模像样、正经流畅的表述,实则是错误的或不符合事实的。幻觉的存在严重影响大模型的可靠性和可信度。

造成幻觉的原因是多众多样的,比如使用充斥噪声的数据进行训练、模型的参数知识存在偏向,还有训练与实际应用中的解码差异等等。

业界一些做法是通过搜索的增强、知识增强的图谱等外挂的形式来提高大模型开卷考试的能力,但腾讯团队认为在这种做法在实际场景中有很大的局限性,很容易出现生搬硬套、“张冠李戴”的现象。蒋杰举了一个“关公战秦琼”的例子。

关公和秦琼谁更强?

关公和秦琼谁更强?

腾讯则采用了一种基于探针的技术,在预训练阶段就去优化目标函数,来把这个问题解决掉。这比目前市场上常见的开源大模型Llama,都有效降低了30%~50%的幻觉率。其次,大模型学会识别陷阱、拒绝诱惑能力也大大增强,拒绝回答率提高了20%。

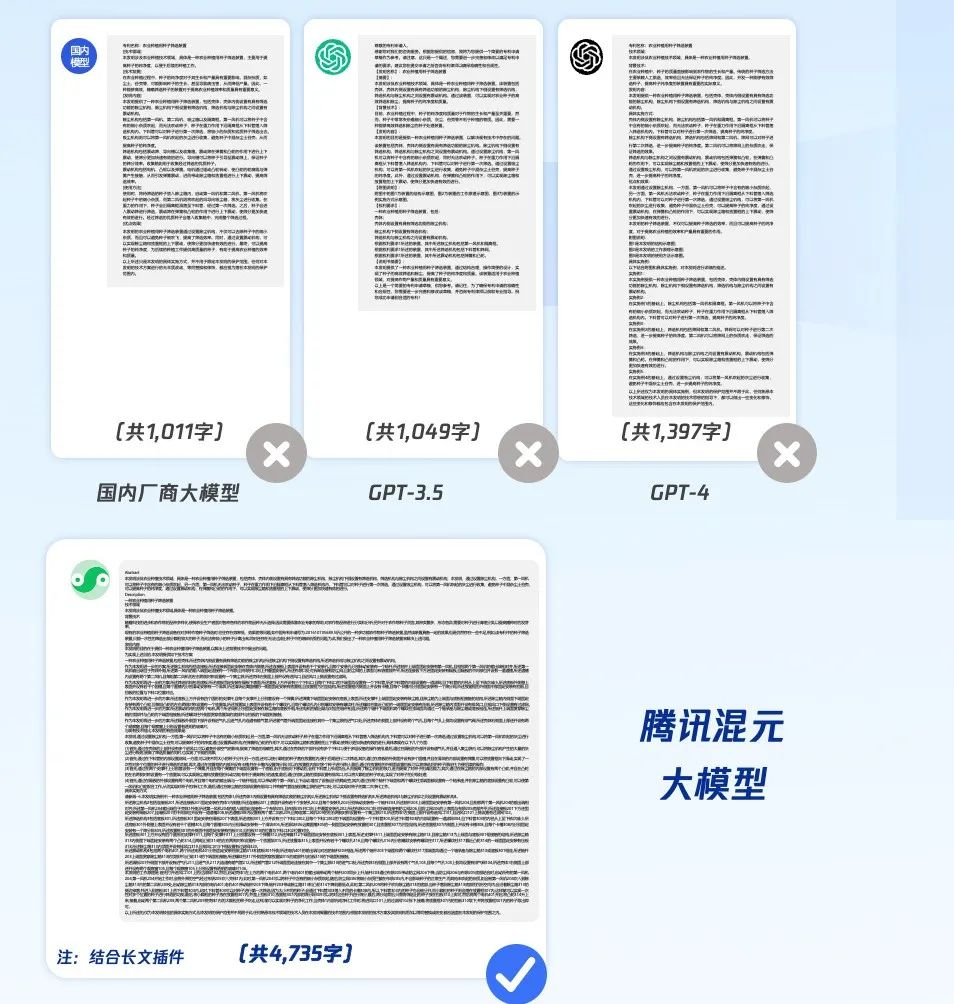

第二,在处理超长文本任务方面,即便号称能力最强的GPT4,也不能生成超出4000字,而混元大模型通过位置编码优化,提升了长文本的处理效果和性能,结合指令跟随的优化,让产出的内容更符合字数要求,这样可以给大模型应用带来“突破桎梏”般的体验:支持超长文本的生成和续写,专利、短篇小说可以说都有了辅助的AI方案了。

GPT4做不到的任务:超过4000字的生成的任务,内容必须符合主题

GPT4做不到的任务:超过4000字的生成的任务,内容必须符合主题

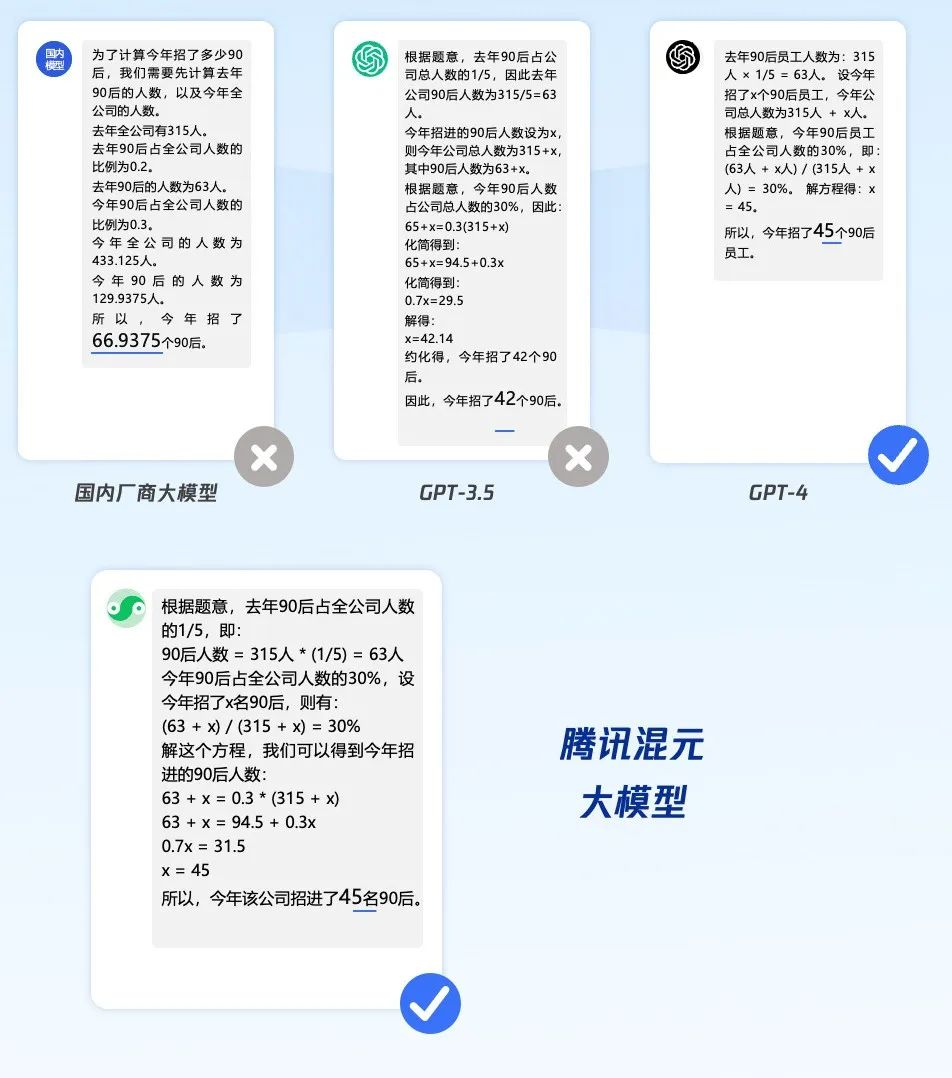

第三,现实场景中的逻辑思维能力更强。背题库中的问题不如能结合语境识别出真正的问题。就比如这样一道有关“90后员工招聘”的接地气的问题(只有GPT4和混元都答对了,GPT3.5和其他模型答错了):

公司去年315名员工,90后员工占比1/5 ,今年又招了一批90后员工,90后员工占比达到了公司人数的30%,请问,今年招了多少90后员工?

图片

图片

2、很争气:全链路自研创新

混元大模型在正式亮相时还伴随着一个令人印象深刻的标签——“全链路自研”。

蒋杰对此解释道:“开源大模型并不适应腾讯海量高并发场景,自研才能完全掌握技术内核,将大模型更好地融入到腾讯的技术栈中。”

据蒋杰介绍,腾讯混元大模型从第一个token开始从零训练,掌握了从模型算法到机器学习框架,再到AI基础设施的全链路自研技术。覆盖了从大规模、高质量、多样化的语料库,到创新的大模型算法,再到自研 Angel 机器学习框架和创新性的训练方法等研发能力。

从2021年开始,腾讯先后推出千亿和万亿参数的NLP稀疏大模型,打破CLUE三大榜单记录,实现在中文理解能力上的新突破。

此外,腾讯还自研了机器学习框架Angel,使训练速度相比业界主流框架提升1 倍,推理速度比业界主流框架提升1.3倍。

3、“实干家”:大模型是道应用题

评测一个新技术,往往会有很多的评测机构或榜单。对于大语言模型而言,外人只看到“霸榜”、“高分”的热闹,看不到的门道却在于,不同的榜单分数就代表着不同的使用场景的适用机会。

腾讯云、腾讯广告、腾讯游戏、腾讯金融科技、腾讯会议、腾讯文档、微信搜一搜、QQ浏览器等超过50个腾讯业务和产品,已经接入腾讯混元大模型测试,并取得初步效果。正如腾讯集团副总裁蒋杰所说:“我们研发大模型的目标不是在评测上获得高分,而是将技术应用到实际场景中。”

比如在广告业务场景,腾讯混元大模型支持智能化的广告素材创作,能够适应行业与地域特色,满足千人千面的需求,实现文字、图片、视频的自然融合。此外,基于混元大模型的能力,广告智能导购能够帮助商家在企业微信等场景,提升服务质量和服务效率。

据了解,混元大模型将作为腾讯云MaaS服务的底座,客户不仅可以直接通过API调用混元,也可以将混元作为基底模型,为不同产业场景构建专属应用。

值得一提的是,此前一天,一款名为“腾讯混元助手”小程序在微信正式上线。这是一款基于混元大模型的用户智能助手,可以回答各类问题,也能处理多种任务,如: 获取知识、解决数学问题、翻译、提供旅游攻略、工作建议等,目前“腾讯混元助手”小程序仅限受邀用户体验,有兴趣的朋友也可申请排队审核体验。

4、写在最后:大模型是持久战,腾讯很稳

此前有媒体报道,国内将有11家大模型陆续通过《生成式人工智能服务管理暂行办法》备案,腾讯也在其中。政策利好,国产AI大模型从狂飙突进到追求实用至上,“大模型之争”的风已经吹向了“大模型应用之争”,大模型之战正迎来新拐点。

如果说参数之争体现的是基础研发的底座能力,那么应用之争才是决定能否在站稳脚跟的绝对竞争力。“百模大战”显然已经进入到应用赛道的角逐阶段,然而对于AIGC时代而言,依然只是刚刚开始。

App商店里上架并不能代表一帆风顺,即便强悍如OpenAI的ChatGPT,同样也经历了“判若峰谷”的考验,巨大的算力消耗及团队招募带来的资金成本以及能否有足够多的用户共建生态,是国内大模型的制胜关键所在。

如何让语言大模型真正在实际场景中满足用户的工作生活所需,够不够准确?够不够快?够不够创新性?够不够安全?都是一款大模型产品要反复拷问自己的问题。

而对于腾讯而言,打磨产品体验,创新应用场景,从来都是不是很难回答的问题,毕竟,庞大的用户和生态已然形成,剩下的,也许只是时间。