Llama 3没能逼出GPT-5!OpenAI怒“卷”To B战场,新企业级 AI 功能重磅推出!

编译 | 伊风

出品 | 51CTO技术栈(微信号:blog51cto)

Meta 是本周当之无愧的AI巨星!刚刚推出的 Llama 3 凭借着强大的性能和开源生态的优势在 LLM 排行榜上迅速跃升。

按理说,Llama 3在开源的状态下做到了 GPT-3.7 的水平,必然会显得用户(尤其是企业用户,他们更具备独立部署Llama 3的能力)花钱买来的 GPT-4 没那么香了。网友于是纷纷拱火,“鼓励”OpenAI 交出 GPT-5,才能继续稳坐大模型王位。

不单单是网友,就连 OpenAI 的研究员也有点坐不住了,跑到X上发了一条含义暧昧的推文。

图片

图片

这下网友更加焦急地推测,性能强悍的 Llama 3 可能会扰乱 GPT-5 的发布时间表,甚至提前到4.22日。

直到周四,OpenAI的新动作才姗姗来迟。

图片

图片

OpenAI 重磅推出了其扩展的 API 客户的企业级功能,进一步丰富其助手 API,并引入旨在增强安全性和行政控制以及更有效管理成本的新工具。

OpenAI对它寄予厚望:“当你与开发者和企业谈论 AI 模型的有意义工作时,OpenAI 仍然领先,”OpenAI API 产品负责人 Olivier Godement说。

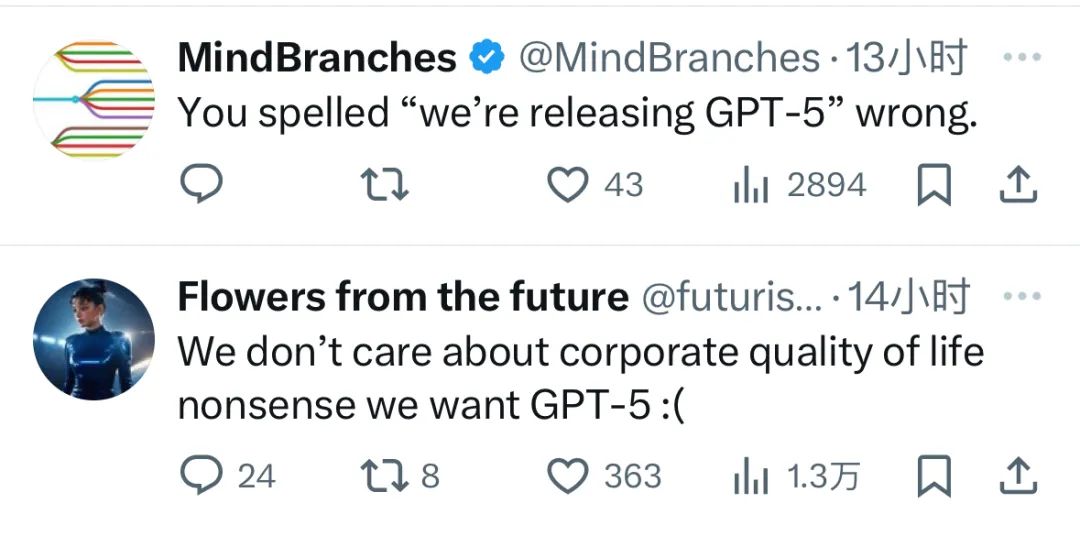

不过,OpenAI这一迂回作战的策略,到底是让很多人始料不及。“油盐不进”的网友回复道,“你是不是把GPT-5拼错了”?

图片

图片

不过,就像小扎曾在采访里坦言,Meta会开源模型,但不会开源产品。过硬的产品才是一家企业真正的技术壁垒和现金牛。一味烧钱的时代过去了,现在的AI主旋律是探索更多的商业价值。

OpenAI在此时高调宣布升级企业级产品,足可见其在To B赛道厮杀的决心。那么这款新升级的API的能力是否能让企业心动到为其买单呢?

1.私有链接和加强的安全功能

在重要的安全升级中,新的API产品引入了私有链接,这种安全方法允许 Microsoft 的 Azure 云服务和 OpenAI 之间进行直接通信,这有助于最小化通过 API 发送的客户数据和查询的“对开放互联网的暴露”。

这一新增功能补充了现有的安全栈,包括 SOC 2 Type II 认证、单点登录(SSO)、静态 AES-256 数据加密、传输中的 TLS 1.2 加密和基于角色的访问控制。

此外,OpenAI 引入了原生的多因素认证(MFA)以加强访问控制,以符合日益增长的合规性需求。

对于需要 HIPAA 合规性的医疗保健公司,OpenAI 继续提供商业伙伴协议,并为符合条件的 API 客户提供零数据保留政策。

2.升级的助手 API,可处理 500 倍更多的文件

OpenAI 提供的一个较少宣传但最重要的企业产品是其助手 API。它允许企业部署他们训练的定制微调模型,并通过检索增强生成(RAG)调用特定文档,并提供相应的会话助手。

例如,电子商务公司 Klarna 今年早些时候夸赞其使用 OpenAI 助手 API 制作的 AI 助手,能够完成 700 名全职人类代理的工作,重复查询减少了 25%,解决时间几乎减少了 82%(从 11 分钟减少到 2 分钟)。

OpenAI 现已升级助手 API,包括新的“file_search”功能,增强文件检索能力,每个助手可以处理多达 10,000 个文件。

这代表了比以前限制的 20 个文件增加了 50 倍,并增加了并行查询、改进的重新排名和查询重写等附加功能。

此外,API 现在支持流式传输,以实时会话响应——这意味着像 GPT-4 Turbo 或 GPT-3.5 Turbo 这样的 AI 模型将尽可能快地返回输出,而不是等待完整响应的生成。

它进一步集成了新的“vector_store”对象以更好地管理文件,并提供更细粒度的令牌使用控制,以帮助有效管理成本。

3.新功能“项目”,可控制人员对特定任务的访问

一个名为“Projects”的新功能提供了改进的行政监督,允许组织在项目级别中管理角色和 API 密钥。

此功能允许企业客户限定权限、控制可用模型,并设置基于使用的限额以避免意外成本——这些增强功能承诺显著简化项目管理。

本质上,他们可以将一个微调版本的 AI 模型甚至一个普通的模型隔离到特定的任务或文档集,并允许特定的人员在每个任务上工作。

因此,如果你的企业有一个团队正在处理一组面向公众的文档,另一个团队正在处理一组机密或内部文档,你可以在 OpenAI 的 API 内为每个分配一个单独的项目,两者可以使用 AI 模型分别工作,而不会混合或危及后者。

“随着越来越多的组织甚至单独的开发者部署 AI,他们希望在受限的盒子里做事,”OpenAI 的产品团队成员 Miqdad Jaffer 在昨天与 外媒 VentureBeat 进行的相同视频电话采访中说。“‘项目’让你做的是将你的资源、你的成员隔离到一个小型的个性化项目中。你得到了单独的使用报告。你有能力控制访问、安全、延迟、吞吐量和成本,一个组织确实可以以非常安全的方式构建。如果你是一个单独的开发者,你可以毫无顾虑地部署数百个项目。”

最后一点对于同时咨询或处理多个客户的开发团队特别有帮助。

4.还有一些新的升级

为了进一步帮助组织以经济方式扩展其 AI 运营,OpenAI 引入了新的成本管理功能。

这些包括为每分钟保持一致水平的令牌使用量的客户提供折扣率,并通过新的 Batch API 为异步工作负载提供成本降低 50%,该 API 还具有更高的速率限制,并承诺在 24 小时内提供结果。

然而,要使用它,客户必须在单个请求中一起发送他们的令牌批次——他们想要 AI 模型分析的输入,无论是提示还是文件——并愿意等待最多 24 小时以从 OpenAI 的 AI 模型接收响应。

虽然这看起来像是很长时间,但 OpenAI 的高管告诉 VentureBeat,返回可以快至 10-20 分钟。

它还旨在为不需要 AI 模型即时响应的客户和企业设计,比如一个调查记者研究长篇特写文章,想要发送一堆政府文件让 OpenAI 的 GPT-4 Turbo 筛选并挑选出选定的细节。

或者,一个企业准备一份报告,查看其过去几周的财务表现,而不是几天或几分钟内到期。

随着 OpenAI 继续增强其产品,专注于企业级安全、行政控制和成本管理,更新表明该公司有兴趣为企业直接提供更“即插即用”的体验,以应对 Llama 3 的升空和像 Mistral 这样可能需要企业方面进行更多设置的开放模型的崛起。

参考链接:https://venturebeat.com/ai/openai-shrugs-off-metas-llama-3-ascent-with-new-enterprise-ai-features/